Chaque jour, des milliards de fois, l’humanité accomplit un acte qui relève presque de la magie : poser une question à une boîte de dialogue et recevoir, en une fraction de seconde, une liste de réponses pertinentes puisées dans les profondeurs d’un réseau de plus d’un milliard de sites web. Cette magie quotidienne, nous la devons aux moteurs de recherche. Mais derrière la simplicité de la page d’accueil de Google, Bing ou Qwant se cache l’une des architectures informatiques les plus complexes jamais créées.

Comment une machine peut-elle lire, comprendre et classer la quasi-totalité de la connaissance humaine accessible en ligne ? Ce n’est ni de la chance, ni de la sorcellerie. C’est le résultat d’un processus logique, constant et incroyablement puissant qui se déroule en trois actes fondamentaux : l’exploration (crawl), l’indexation et le classement (ranking).

Cet article vous invite à un voyage dans les coulisses du web pour démystifier cette mécanique fascinante. Préparez-vous à découvrir les explorateurs numériques infatigables, les bibliothécaires virtuels et les juges algorithmiques qui orchestrent notre accès au savoir.

L’exploration (Crawl) : à la découverte du web infini

Avant de pouvoir répondre à une question, un moteur de recherche doit d’abord savoir ce qui existe sur le web.

C’est le rôle de la première étape : le crawl.

Les explorateurs numériques : crawlers et spiders

Imaginez une armée d’explorateurs infatigables dont la seule mission est de cartographier le monde numérique. Ces explorateurs sont des programmes informatiques, des robots appelés « crawlers » ou « spiders » (araignées). Le plus célèbre d’entre eux est Googlebot.

Leur travail ne commence pas au hasard. Les moteurs de recherche maintiennent une liste d’URL connues et fiables, appelée « seed list » (liste de départ), qui constitue leur point de départ. Un crawler commence par visiter les pages de cette liste. En lisant le code de ces pages, il identifie tous les liens hypertextes (<a href= »… »>) qui pointent vers d’autres pages. Chaque lien découvert est une nouvelle destination potentielle, qui est ajoutée à la liste des pages à visiter.

En suivant ainsi les liens de page en page, les crawlers tissent une toile (d’où le nom de « spiders ») et parcourent le World Wide Web, découvrant constamment de nouvelles pages, de nouveaux sites, des mises à jour de contenus existants ou des liens morts. C’est un processus sans fin, car le web est en perpétuelle évolution.

La feuille de route : Sitemap et Robots.txt

Pour aider ces explorateurs, les propriétaires de sites web peuvent leur fournir deux documents essentiels :

- Le fichier sitemap.xml : C’est littéralement un plan du site. Ce fichier, que le webmaster soumet au moteur de recherche, liste toutes les pages jugées importantes sur un site. Il peut même indiquer la date de dernière modification de chaque page et sa fréquence de mise à jour. Pour le crawler, c’est une feuille de route précieuse qui lui assure de ne manquer aucun contenu stratégique.

- Le fichier robots.txt : Si le sitemap dit « voici les lieux à visiter », le robots.txt indique les zones à ignorer. Placé à la racine d’un site, ce fichier texte donne des instructions aux robots, leur interdisant l’accès à certaines sections. Pourquoi interdire l’accès ? Pour éviter que les crawlers ne perdent leur temps à explorer des pages sans intérêt pour le grand public, comme des pages d’administration, des résultats de recherche internes ou le contenu d’un panier d’achat.

La gestion du « crawl budget » (budget d’exploration) est cruciale. Les moteurs de recherche allouent un temps et des ressources limités pour explorer chaque site. Un site bien structuré, rapide, avec un sitemap clair et un robots.txt bien configuré, optimise ce budget et s’assure que ses pages les plus importantes sont explorées fréquemment.

L’indexation : construire la bibliothèque du monde

Avoir découvert des milliards de pages ne sert à rien si l’information n’est pas stockée, comprise et organisée. C’est le rôle de l’indexation : transformer le chaos des données brutes en une bibliothèque structurée.

De la page à l’entrée de catalogue

Une fois qu’une page a été crawlée, son contenu est analysé pour être ajouté à une gigantesque base de données appelée l’index. Pensez à l’index comme à la plus grande bibliothèque du monde. Le crawler est le livreur qui apporte les livres (les pages web), et l’indexeur est le bibliothécaire qui les traite.

Ce traitement est très sophistiqué. Le moteur de recherche ne se contente pas de sauvegarder le texte brut. Il décompose la page pour en comprendre la structure et la signification :

- Il identifie les titres et sous-titres (balises HTML <title>, <h1>, <h2>, etc.).

- Il analyse le contenu textuel pour en extraire les mots et les concepts clés.

- Il prend en compte les attributs des images (comme la balise alt), les transcriptions de vidéos, les données structurées, et bien plus encore.

Le secret de la vitesse : l’index inversé

Pour pouvoir retrouver une information en une fraction de seconde, les moteurs de recherche utilisent une structure de données brillante : l’index inversé.

Un index classique associe un document à une liste de mots qu’il contient (Page A -> contient « recette », « gâteau », « chocolat »). C’est peu efficace pour la recherche. Un index inversé, comme son nom l’indique, fait l’inverse : il associe chaque mot à la liste de tous les documents qui le contiennent.

Par exemple :

- « Recette » -> Page A, Page C, Page H…

- « Gâteau » -> Page A, Page F, Page G…

- « Chocolat » -> Page A, Page H, Page K…

Ainsi, lorsque vous tapez « recette gâteau au chocolat », le moteur n’a pas à lire tout le web. Il va instantanément chercher dans son index inversé les listes de pages correspondant à « recette », « gâteau » et « chocolat », puis croise ces listes pour trouver les pages qui contiennent les trois termes (comme la Page A). C’est ce qui permet d’obtenir des résultats quasi instantanés.

La gestion des doublons : La canonicalisation

Le web est rempli de contenus dupliqués. Une même page peut souvent être accessible via plusieurs URL (par exemple, http://site.com, https://site.com, https://www.site.com). Pour éviter de stocker des doublons et de diluer la « valeur » d’une page sur plusieurs URL, les moteurs de recherche doivent identifier la version originale ou préférée. C’est le processus de canonicalisation. Les webmasters peuvent aider en utilisant une balise rel= »canonical » pour indiquer clairement quelle est l’URL maîtresse qui doit être indexée.

Le classement (Ranking) : le jugement final

Une fois l’index construit, le travail le plus complexe commence : le classement. Pour une requête donnée, il peut y avoir des milliers, voire des millions, de pages pertinentes dans l’index. Comment décider lesquelles afficher en premier ? C’est le rôle des algorithmes de classement.

Ces algorithmes sont le secret commercial le mieux gardé des moteurs de recherche. Il ne s’agit pas d’une seule formule, mais d’un système complexe de centaines de signaux et de sous-algorithmes qui travaillent de concert. On peut les regrouper en quelques grandes familles de facteurs.

La pertinence : comprendre le contenu et l’intention

Au début du web, la pertinence était simple : une page était considérée comme pertinente si elle contenait les mots-clés de la recherche. Aujourd’hui, c’est bien plus subtil. Grâce à l’intelligence artificielle, les moteurs pratiquent la recherche sémantique. Ils ne se contentent pas de comprendre les mots, ils cherchent à comprendre l’intention derrière la requête.

Des algorithmes comme BERT ou MUM permettent à Google de saisir le contexte, les synonymes et les nuances du langage naturel. Il sait que si vous tapez « meilleur réalisateur de Le Parrain« , vous cherchez « Francis Ford Coppola ». Il comprend que la requête « température jaguar » fait probablement référence à la voiture, et non à l’animal. Cette compréhension profonde du sens permet de fournir des résultats qui ne contiennent pas forcément les mots exacts de la requête, mais qui y répondent parfaitement.

L’autorité et la confiance : le concept d’E-E-A-T

Pour départager deux pages également pertinentes, Google évalue leur fiabilité avec l’E-E-A-T. Le concept fondateur était le PageRank, un algorithme qui considérait chaque lien externe (backlink) comme un « vote de confiance ». L’idée, toujours d’actualité, est qu’une page qui reçoit de nombreux liens provenant d’autres sites sérieux et réputés est probablement une source d’information fiable.

- Experience (Expérience vécue) : Le contenu est-il créé par quelqu’un ayant une expérience directe du sujet ?

- Expertise (Compétence) : L’auteur est-il un expert reconnu dans son domaine ?

- Authoritativeness (Autorité) : Le site dans son ensemble est-il une référence sur le sujet ?

- Trustworthiness (Fiabilité) : Le site est-il sécurisé (HTTPS) ? Les informations sont-elles exactes et transparentes ?

Pour des sujets sensibles (« Your Money or Your Life » – santé, finance), ces critères sont particulièrement importants.

L’expérience utilisateur (UX)

Un bon résultat n’est pas seulement pertinent et fiable, il doit aussi être agréable à consulter.

Google intègre donc de plus en plus de signaux liés à l’expérience utilisateur, notamment :

- La vitesse de chargement (mesurée par les Core Web Vitals).

- La compatibilité mobile (le site est-il facile à utiliser sur un smartphone ?).

- La sécurité (l’utilisation du protocole HTTPS).

- L’absence de publicités intrusives.

Le contexte et la personnalisation

Enfin, les résultats de recherche ne sont pas universels, ils sont ajustés en fonction du contexte de l’utilisateur :

- La localisation : une recherche pour « restaurant à Grenoble » donnera des résultats complètement différents à Voiron et à Marseille.

- L’historique de recherche : vos recherches précédentes peuvent influencer les résultats futurs.

- La langue et les paramètres du navigateur.

Conclusion : un écosystème en constante évolution

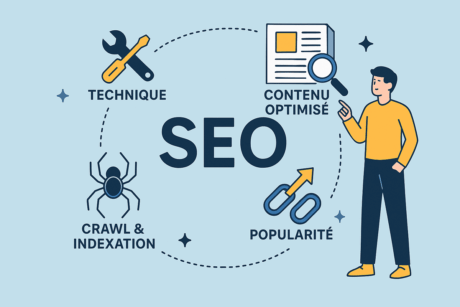

L’exploration, l’indexation et le classement : ce triptyque est le fondement du fonctionnement de tous les moteurs de recherche modernes.

C’est une symphonie mécanique et algorithmique d’une complexité inouïe, qui vise un objectif unique : apporter la réponse la plus pertinente, la plus fiable et la plus rapide à la question d’un utilisateur.

Loin d’être figé, cet écosystème est en révolution permanente. L’intelligence artificielle, et notamment l’IA générative, est en train de remodeler l’expérience de recherche, en proposant des réponses directes et conversationnelles.

Mais même derrière ces nouvelles interfaces, les principes fondamentaux demeurent. Comprendre cette mécanique n’est pas seulement une curiosité technique ; c’est la clé pour créer des contenus de qualité, construire une présence en ligne visible et, finalement, participer de manière efficace à la grande conversation du savoir humain.

Alors, prêt à passer de l’ombre à la lumière et viser la première page de Google ?

Ne laissez plus vos concurrents capter toute l’attention en ligne.

Il est temps de faire du référencement naturel (SEO) un véritable levier de croissance durable pour votre PME.

📞 Planifions un appel découverte gratuit de 30 minutes.

Lors de cet échange sans engagement, nous analyserons votre présence actuelle sur Google, identifierons les axes d’optimisation SEO et vous proposerons une feuille de route réaliste et orientée rentabilité.

➡️ Cliquez ici pour réserver votre appel gratuit